Patricia Bezunarea, directora general de Diversidad Familiar (arriba en el centro) con los premiados, miembros del Jurado y patrocinadores del Premio SFS2024.

El documento, elaborado por DATAI (Universidad de Navarra), responde a las recomendaciones de la UE para las aplicaciones de IA en usos calificados de alto riesgo

El procedimiento parte de la investigación empírica realizada en 7 empresas que utilizan algoritmos en diversos procesos de RRHH y en 3 casos analizados de estrategia de Gobernanza del dato

Madrid, 29 de julio de 2025 – El proyecto IA+Igual lanza el Libro Blanco Un enfoque practico, ético y normativo para desarrollar un estándar de certificación de IA en el ámbito laboral. El documento ha sido elaborado por un equipo de científicos y académicos del Instituto de Ciencias del Dato e Inteligencia Artificial (DATAI) de la Universidad de Navarra, partner académico del proyecto. Este Libro Blanco, realizado con la información recogida en el análisis empírico de 7 algoritmos utilizados en diversos procesos de RRHH y 3 casos sobre estrategia de Gobernanza del dato, es una propuesta de actuación sobre el impacto discriminatorio de los sesgos en el ámbito laboral y responde a las recomendaciones de supervisión algorítmica de la UE.

El objetivo principal del Libro Blanco es fomentar el entendimiento y la implementación de la IA en los procesos de gestión de personas, con especial atención a sus implicaciones éticas, legales y organizativas. José Luis Poveda Marina, investigador transferencia de DATAI y coautor del Libro Blanco, destaca que “a través de análisis de casos reales, se ilustran los impactos transformadores de estas tecnologías en el ámbito laboral, se lleva a cabo una revisión crítica de las normativas vigentes en materia de privacidad de datos y cumplimiento regulatorio y se plantean desafíos futuros entre ellos, la necesidad de que las soluciones de IA sean escalables, adaptables y sostenibles en un entorno de trabajo dinámico interconectado y en permanente evolución”.

IN2, an Altia Company, ha sido la responsable de aportar el conocimiento para la elaboración del contenido técnico del documento. basándose en los análisis de algoritmos, los casos de uso y la experiencia de la compañía. El equipo de analistas de datos ha desarrollado una metodología que ha ido evolucionando durante el proyecto y que se ha visto completada por la visión multidisciplinar del Consejo Asesor.

Principales retos y conclusiones

El Libro Blanco está dividido en cinco capítulos: IA en el ámbito laboral, marco legal para implantar la IA en el ámbito laboral, investigación empírica de IA aplicada a RRHH, recomendaciones para la certificación de sistemas aplicados a RRHH y retos futuros y conclusiones. Además, incluye un glosario y una completa bibliografía.

Entre los retos planteados en el curso del proyecto, el documento destaca:

- La transformación que está sufriendo el mercado laboral hace imprescindible:

- Entender que no toda la innovación tecnológica es neutral ni beneficiosa por defecto

- Asegurar que la IA se despliega con perspectiva inclusiva, legal y estratégica

- Fortalecer la capacidad crítica de las organizaciones en torno al uso de datos y algoritmos

- El marco de actuación público-privado:

- Reducir las barreras de entrada de la tecnología: evitando que únicamente las grandes empresas puedan implementar IA de forma segura y regulada

- Fomentar la mejora contina: ofreciendo un marco normativo que permita avanzar desde niveles básicos de cumplimiento hasta niveles avanzados de gobernanza y transparencia

- Construir confianza: a todos los niveles, desde los directivos a usuarios, personas candidatas y ciudadanía en general

- En el ámbito legal

- Regulación de los modelos auto aprendientes. Los algoritmos que modifican su comportamiento en tiempo real plantean un gran dilema jurídico: ¿cómo asegurar que un modelo que evoluciona de forma continua mantiene el cumplimiento normativo vigente?

- Estandarización de auditorías algorítmicas. En la actualidad no existe una metodología homogénea para evaluar algoritmos en el ámbito de los RRHH. Es urgente establecer criterios técnicos, éticos y jurídicos estandarizados que permitan evaluar comparativamente distintos sistemas certificar su uso y generar confianza en su despliegue

- Gobernanza del dato en entornos federados. El machine Learning federado y otros sistemas de procesamiento de datos abren grandes oportunidades a la protección de la privacidad pero también hacen más compleja la atribución de responsabilidades y la garantía de los derechos digitales

- Responsabilidad en IA generativa aplicada a RRHH. La expansión de esta tecnología (que redacta informes, elabora perfiles de talento) introduce una nueva dimensión en la toma de decisiones a partir de resultados automatizados. Será esencial definir quién responde por la información generada, cómo se valida y en qué condiciones puede formar parte en un proceso formal de selección o evaluación.

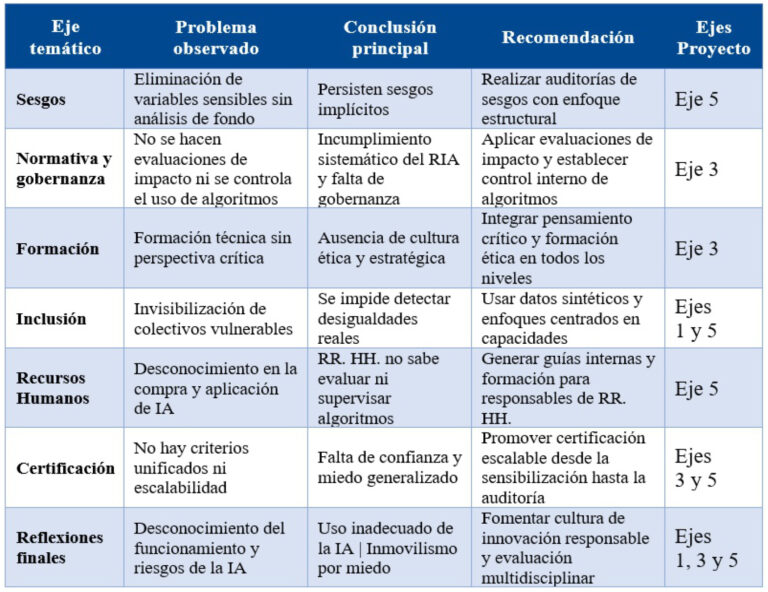

Tras el análisis del nuevo escenario laboral, los requisitos para la escalabilidad viable de soluciones y los retos legales emergentes, se consolidan las siguientes conclusiones:

- Sesgos en el diseño y uso de algoritmos. Uno de los hallazgos más preocupantes es la presencia de sesgos no detectados. Con el objeto de evitar discriminaciones las organizaciones eliminan variables cómo género o discapacidad. Sin embargo, esta práctica no garantiza la neutralidad, sino que pueden ocultar sesgos implícitos que se mantienen a través de variables correlacionadas.

- Falta de análisis técnicos rigurosos para identificar sesgos potenciales. Existe una falta de comprensión generalizada sobre cómo los sesgos pueden surgir de forma estructural y cómo deben abordarse.

- El impacto de los sesgos es especialmente grave en colectivos vulnerables, cuya invisibilización puede comprometer directamente las oportunidades de empleabilidad.

- Gobernanza del dato. La velocidad con la que se produce la transformación digital y las exigencias de competitividad, dificultan la realización de evaluaciones de impacto. El vacío normativo se agrava por la falta generalizad de estrategias de Gobernanza del dato.

- Inclusión social y colectivos invisibilizados. La eliminación de variables sensibles en el histórico de datos ha llevado a la invisibilización de colectivos vulnerables. El cumplimiento de la LGPD impide realizar análisis que identifiquen desigualdades estructurales.

- La falta de preparación generalizada en el ámbito profesional para evaluar, seleccionar e implementar sistemas de IA. Esta realidad tiene como consecuencia que no se realicen análisis de impacto, que no se consideren alternativas tecnológicas menos invasivas y que no se solicite a los proveedores el cumplimiento normativo de criterios de explicabilidad y proporcionalidad.

- Certificación ética y progresiva. Existe la necesidad de establecer mecanismos de certificación ética adaptados al grado de madurez de cada organización. Al mismo tiempo, se facilitaría la difusión de una cultura ética desde la base, ofreciendo seguridad jurídica y metodológica a las organizaciones.

- Triple reto en innovación social

- Cualificar a los profesionales para el uso ético de la IA

- Reconocer a los colectivos vulnerables en los datos

- Impedir que la tecnología agrave la desigualdad o perjudique los ODS

En la elaboración del Libro Blanco ha participado gran parte de la red colaborativa del proyecto. La coordinadora del proyecto y directora técnica del Libro Blanco, Marisa Cruzado, ha señalado que “estamos ante un reto del presente que marcará el futuro que nos tocará vivir. Por eso es necesario contar con aportaciones multidisciplinares que nos faciliten una visión 360º real para integrar la IA en todos los procesos humanos, no solo en el laboral. Estamos a tiempo de prepararnos, formarnos y tomar las decisiones necesarias, cada uno desde nuestra posición, para garantizar que la IA se convierta en un copiloto de nuestro desempeño y contribuya a fortalecer nuestra visión europea de la sociedad: una inclusiva, equitativa y diversa que sabemos nos hace más eficientes, productivos, rentables y socialmente responsables”.

Sobre el Proyecto

IA+Igual es un proyecto cofinanciado con Fondos Next Generation (UE) a través de la Dirección General de Evaluación, Calidad e Innovación, de la Consejería de Familia, Juventud y Asuntos Sociales de la Comunidad de Madrid, a través del Plan de Recuperación, Transformación y Resiliencia del Ministerio de Derechos Sociales y Agenda 2030 del Gobierno de España. Se trata de un proyecto piloto, innovador en materia de Asuntos Sociales cuyo objetivo fundamental es analizar y verificar los algoritmos de Inteligencia Artificial aplicados en el ámbito de RR. HH para identificar los sesgos en su programación e impulsar una IA más ética e igualitaria dentro del ecosistema empresarial.